背景介绍

电商平台中有海量的非结构化文本数据,如商品描述、用户评论、用户搜索词、用户咨询等。这些文本数据不仅反映了产品特性,也蕴含了用户的需求以及使用反馈。通过深度挖掘,可以精细化定位产品与服务的不足。

用户评论能反映出用户对商品、服务的关注点和不满意点。评论从情感分析上可以分为正面与负面。细粒度上也可以将负面评论按照业务环节进行分类,便于定位哪个环节需要不断优化。

数据

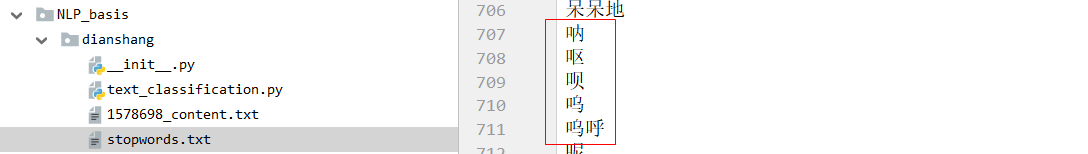

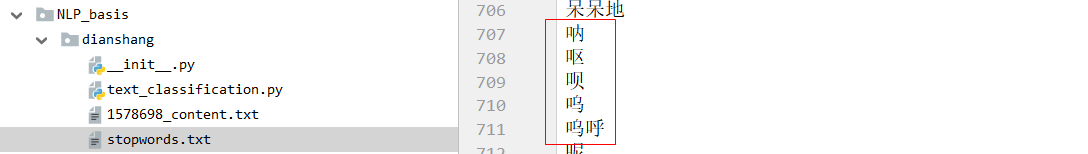

分词词典:

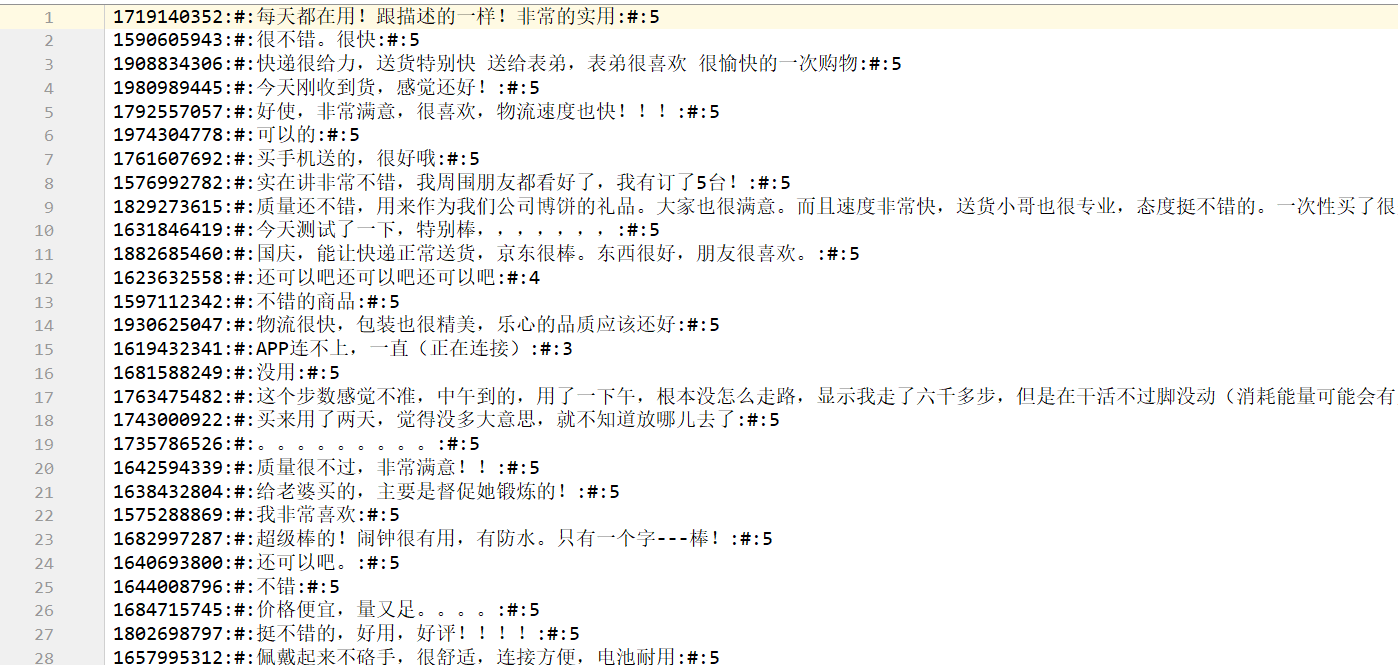

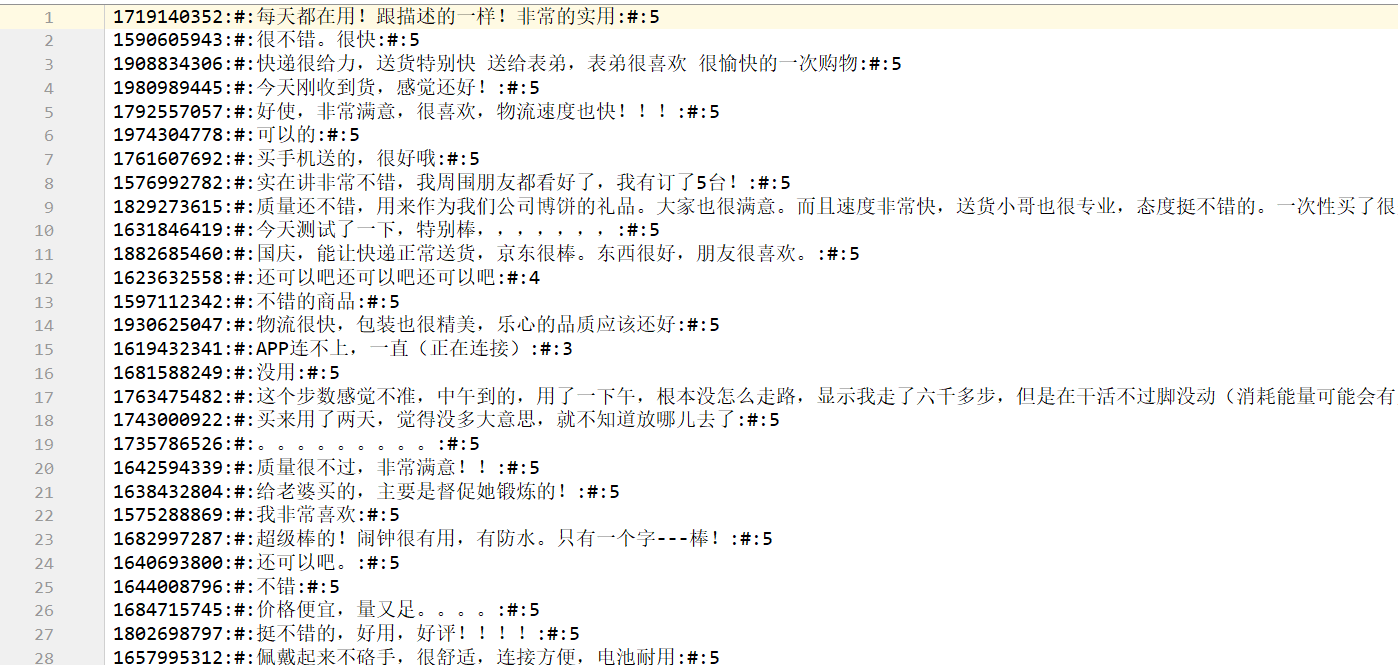

电商评论数据:

代码实现

1 | ''' |

电商平台中有海量的非结构化文本数据,如商品描述、用户评论、用户搜索词、用户咨询等。这些文本数据不仅反映了产品特性,也蕴含了用户的需求以及使用反馈。通过深度挖掘,可以精细化定位产品与服务的不足。

用户评论能反映出用户对商品、服务的关注点和不满意点。评论从情感分析上可以分为正面与负面。细粒度上也可以将负面评论按照业务环节进行分类,便于定位哪个环节需要不断优化。

分词词典:

电商评论数据:

1 | ''' |

numpy系统是Python的一种开源的数值计算包。 包括:1、一个强大的N维数组对象Array;2、比较成熟的(广播)函数库;3、用于整合C/C++和Fortran代码的工具包;4、实用的线性代数、傅里叶变换和随机数生成函数。numpy和稀疏矩阵运算包scipy配合使用更加方便。

1 | conda install numpy |

Natural Language Toolkit,自然语言处理工具包,在NLP领域中, 最常使用的一个Python库。

1 | conda install nltk |

Gensim是一个占内存低,接口简单,免费的Python库,它可以用来从文档中自动提取语义主题。它包含了很多非监督学习算法如:TF/IDF,潜在语义分析(Latent Semantic Analysis,LSA)、隐含狄利克雷分配(Latent Dirichlet Allocation,LDA),层次狄利克雷过程 (Hierarchical Dirichlet Processes,HDP)等。

Gensim支持Word2Vec,Doc2Vec等模型。

1 | conda install gensim |

TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统。TensorFlow可被用于语音识别或图像识别等多项机器学习和深度学习领域。TensorFlow是一个采用数据流图(data flow graphs),用于数值计算的开源软件库。节点(Nodes)在图中表示数学操作,图中的线(edges)则表示在节点间相互联系的多维数据数组,即张量(tensor)。它灵活的架构让你可以在多种平台上展开计算,例如台式计算机中的一个或多个CPU(戒GPU),服务器,移动设备等等。TensorFlow 最初由Google大脑小组(隶属于Google机器智能研究机构)的研究员和工程师们开发出来,用于机器学习和深度神经网络方面的研究,但这个系统的通用 性使其也可广泛用于其他计算领域。

1 | conda install tensorflow |

“结巴”中文分词:是广泛使用的中文分词工具,具有以下特点:

1)三种分词模式:精确模式,全模式和搜索引擎模式

2)词性标注和返回词语在原文的起止位置( Tokenize)

3)可加入自定义字典

4)代码对 Python 2/3 均兼容

5)支持多种语言,支持简体繁体

项目地址:https://github.com/fxsjy/jieba

1 | pip install jieba |

Stanford NLP提供了一系列自然语言分析工具。它能够给出基本的 词形,词性,不管是公司名还是人名等,格式化的日期,时间,量词, 并且能够标记句子的结构,语法形式和字词依赖,指明那些名字指向同 样的实体,指明情绪,提取发言中的开放关系等。 1.一个集成的语言分析工具集; 2.进行快速,可靠的任意文本分析; 3.整体的高质量的文本分析; 4.支持多种主流语言; 5.多种编程语言的易用接口; 6.方便的简单的部署web服务。

1 | Python 版本stanford nlp 安装 |

1 | #-*-encoding=utf8-*- |

HanLP是由一系列模型与算法组成的Java工具包,目标是普及自然 语言处理在生产环境中的应用。HanLP具备功能完善、性能高效、架构 清晰、语料时新、可自定义的特点。 功能:中文分词 词性标注 命名实体识别 依存句法分析 关键词提取 新词发现 短语提取 自动摘要 文本分类 拼音简繁

1 | • 1、安装Java:我装的是Java 1.8 |

1 | • 1、下载hanlp.jar包: https://github.com/hankcs/HanLP |

1 | #-*- coding:utf-8 -*- |

Welcome to Hexo! This is your very first post. Check documentation for more info. If you get any problems when using Hexo, you can find the answer in troubleshooting or you can ask me on GitHub.

1 | $ hexo new "My New Post" |

More info: Writing

1 | $ hexo server |

More info: Server

1 | $ hexo generate |

More info: Generating

1 | $ hexo deploy |

More info: Deployment